L’intelligence artificielle (IA) a été utilisée pour développer divers types de modèles de traduction afin d’améliorer la communication entre les utilisateurs et de briser les barrières linguistiques entre les régions. Des entreprises comme Google et Facebook utilisent l’IA pour développer des modèles de traduction avancés pour leurs services. Aujourd’hui, un étudiant indien en troisième année d’ingénierie a créé un modèle d’IA capable de détecter la langue des signes américaine (ASL) et de la traduire en anglais en temps réel.

Un étudiant indien développe un détecteur ASL basé sur l’IA

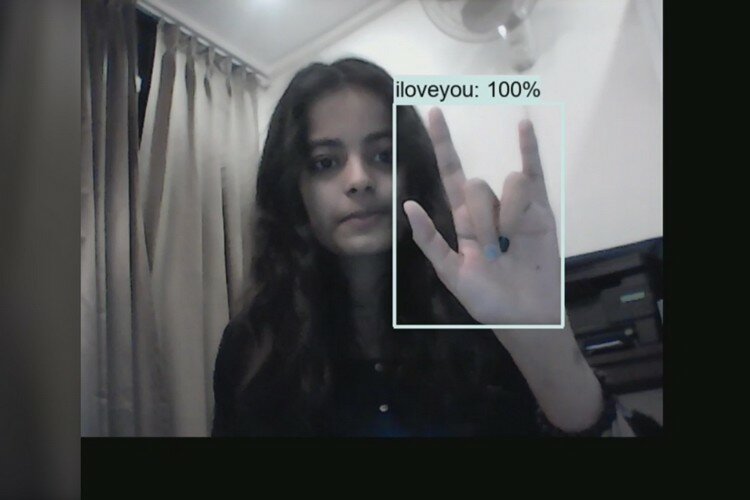

Priyanjali Gupta, étudiante au Vellore Institute of Technology (VIT), a partagé une vidéo sur son profil LinkedIn, présentant une démo du détecteur ASL basé sur l’IA en action. Bien que le modèle d’IA puisse détecter et traduire les langues des signes en anglais en temps réel, il ne prend en charge que quelques mots et phrases pour le moment. Ceux-ci inclus Bonjour, s’il vous plaît, merci, je t’aime, oui, et Non.

Gupta a créé le modèle en tirer parti de l’API de détection d’objets Tensorflow et utiliser l’apprentissage par transfert via un modèle pré-formé appelé ssd_mobilenet. Cela signifie qu’elle a pu réutiliser les codes existants pour s’adapter à son modèle de détecteur ASL. De plus, il convient de mentionner que le modèle d’IA ne traduit pas réellement l’ASL en anglais. Au lieu de cela, il identifie un objet, dans ce cas, les signes, puis détermine à quel point il est similaire sur la base d’objets préprogrammés dans sa base de données.

Dans un entretien avec Ingénierie intéressanteGupta a noté que son la plus grande inspiration pour créer un tel modèle d’IA est sa mère la harceler « faire quelque chose » après avoir rejoint son cursus d’ingénieur au VIT. « Elle m’a nargué. Mais cela m’a fait réfléchir à ce que je pouvais faire avec mes connaissances et mes compétences. Un beau jour, au milieu des conversations avec Alexa, l’idée d’une technologie inclusive m’a frappé. Cela a déclenché une série de plans », a-t-elle déclaré à la publication.

Gupta a également crédité YouTuber et data scientist Nicholas Renotte vidéo de 2020qui détaille le développement d’un détecteur ASL basé sur l’IA, dans sa déclaration.

Bien que la publication de Gupta sur LinkedIn ait suscité de nombreuses réponses positives et appréciées de la part de la communauté, un ingénieur en vision IA souligné que la méthode d’apprentissage par transfert utilisée dans son modèle est « formé par d’autres experts » et c’est le « la chose la plus facile à faire en IA. » Gupta a reconnu la déclaration et a écrit que le bâtiment « Un modèle d’apprentissage en profondeur uniquement pour la détection de signes est un problème vraiment difficile mais pas impossible. »

« Actuellement, je ne suis qu’un étudiant amateur mais j’apprends et je pense que tôt ou tard notre communauté open source, qui est beaucoup plus expérimentée et savante que moi, trouvera une solution et peut-être que nous pourrons avoir des modèles d’apprentissage en profondeur uniquement pour le signe langues », elle a encore ajouté.

Vous pouvez consulter Priyanjali Page GitHub pour en savoir plus sur le modèle d’IA et accéder aux ressources pertinentes du projet. Faites-nous également part de vos réflexions sur le détecteur ASL de Gupta dans les commentaires ci-dessous.